情報リテラシー論13画像認識と生成技術で革新’25長岡造形大学

ChatGPTの画像生成によって

上手に書けましたけど凄いね

イーンスパイアの横田です。

https://www.enspire.co.jp

さて、本題です。

恒例の長岡造形大学で行う

情報リテラシー論の講義が

今年も後期から始まりました。

https://www.nagaoka-id.ac.jp/about/academics/curriculum/liberal-arts/

画像認識と生成技術の革新として

第13回めの講義を行いました。

https://www.youtube.com/watch?v=rXiBXIfXm1U

上記の続きの動画はYouTubeメンバーシップの

デイリー会員(190円/月)に限定公開しています。

詳しくは以下をご覧ください。

https://yokotashurin.com/youtube/membership.html

YouTubeメンバーシップ申込こちら↓

https://www.youtube.com/channel/UCXHCC1WbbF3jPnL1JdRWWNA/join

情報リテラシー論13画像認識と生成技術の革新’25長岡造形大学

生成AIによる動画・音声・スライド・カルーセル・図解による解説は無料

動画解説

https://www.youtube.com/watch?v=nsWwy69RrhY

音声解説

https://www.youtube.com/watch?v=A0dUGPqqczg

スライド解説

https://www.youtube.com/watch?v=eBLj56JoLiM

スライド

https://www.docswell.com/s/6534747/KJQJ8J-2025-12-23-013541

漫画解説

https://www.youtube.com/watch?v=i4Pa0FTTQh4

カルーセル解説

https://www.instagram.com/p/DSkUeL3j4PY/

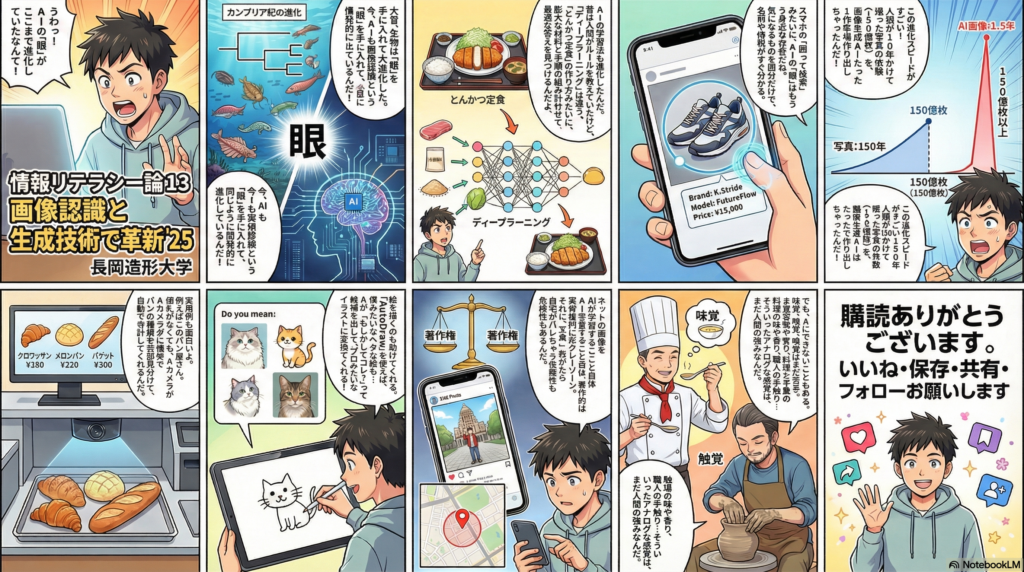

漫画

インフォグラフィック解説

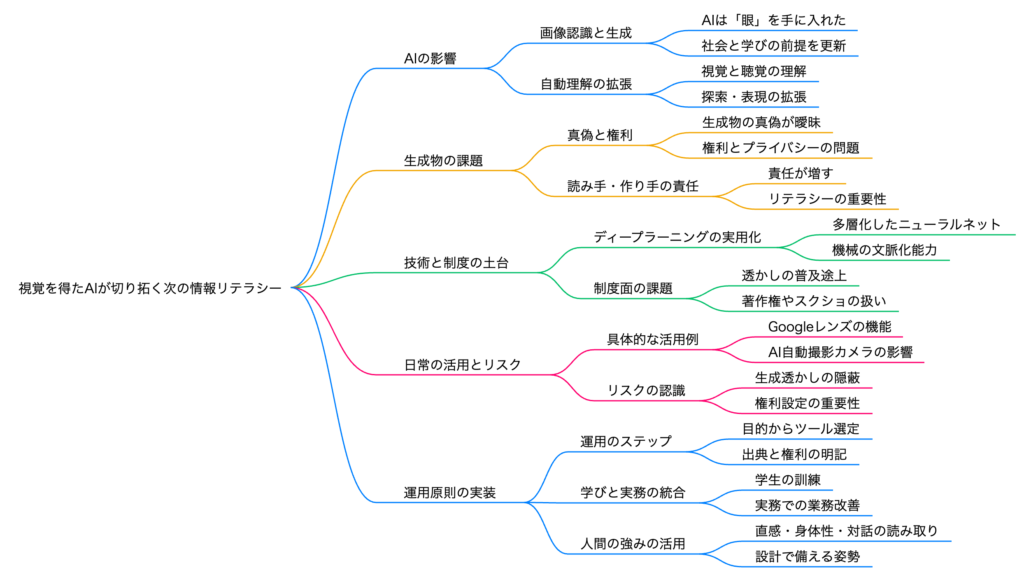

マインドマップ

情報リテラシー論13画像認識と生成技術で革新’25長岡造形大学

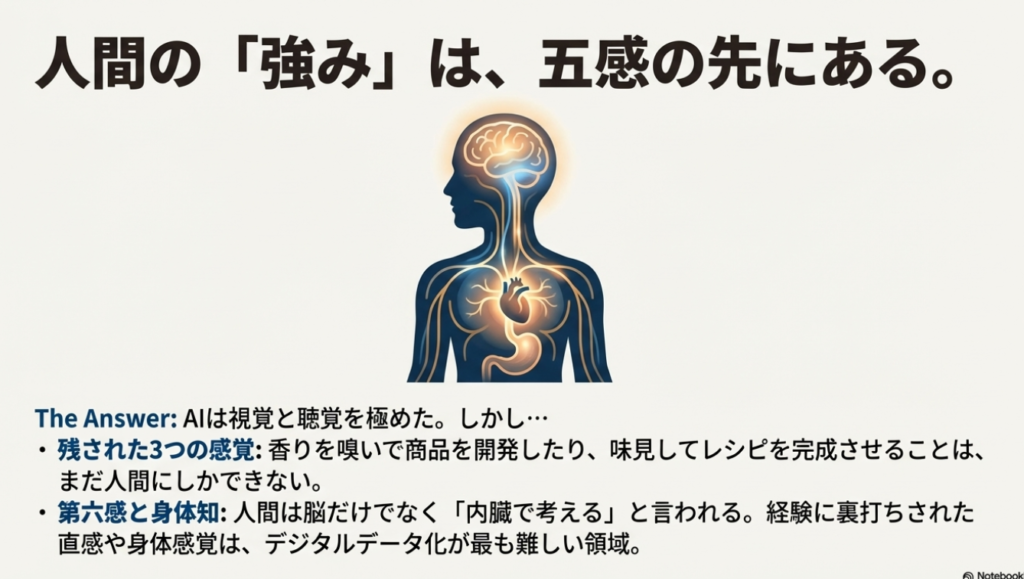

💭 人間の強み

• 第六感は人間だけのもの

• 脳だけでなく体や内臓でも考えている

• 残り3つの感覚は右脳的・人間的強み

人間がルールを決めて学習させる

→ 限定的なパターン認識

とんかつ定食で説明!

→ 大量データから自動学習

🍴 とんかつ定食の例え

多層の階層(ニューラルネットワーク)を深くすることで、より高精度な認識が可能に。パラメーターを大量に与えて数値計算で学習!

親から直接学ぶより、人の会話を聞いて学ぶ

「学ぶ」は「真似ぶ」から!

手書き文字も認識

読めない漢字も検索

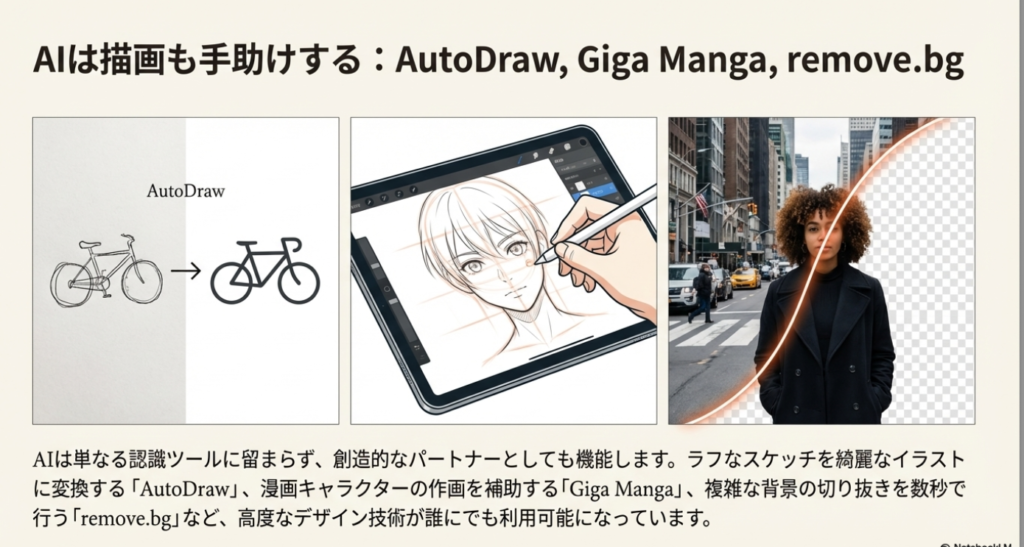

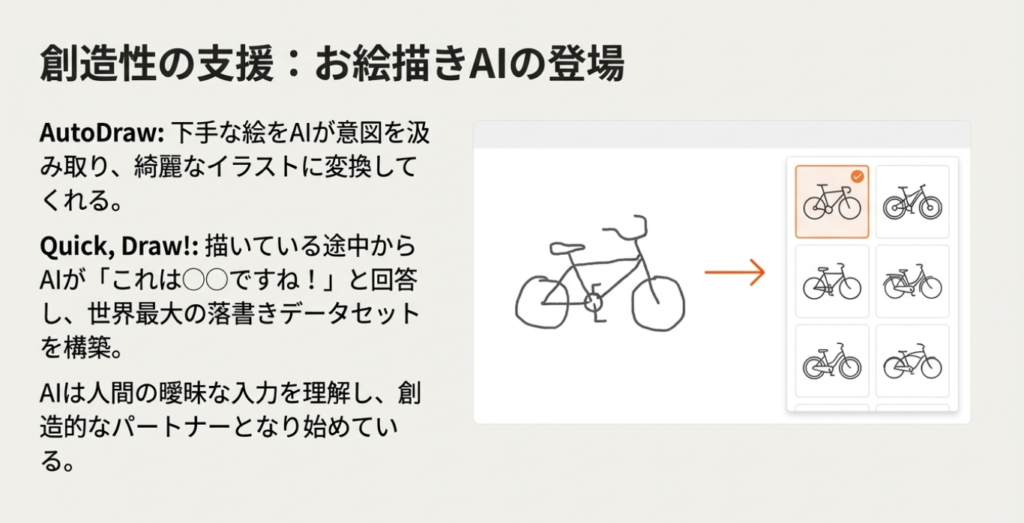

お絵かきをAIが

補正してくれる

AIで漫画キャラ

が描ける

背景を簡単に

消去

なぞるだけで

不要物を消去

LINE画像を

3秒で文字起こし

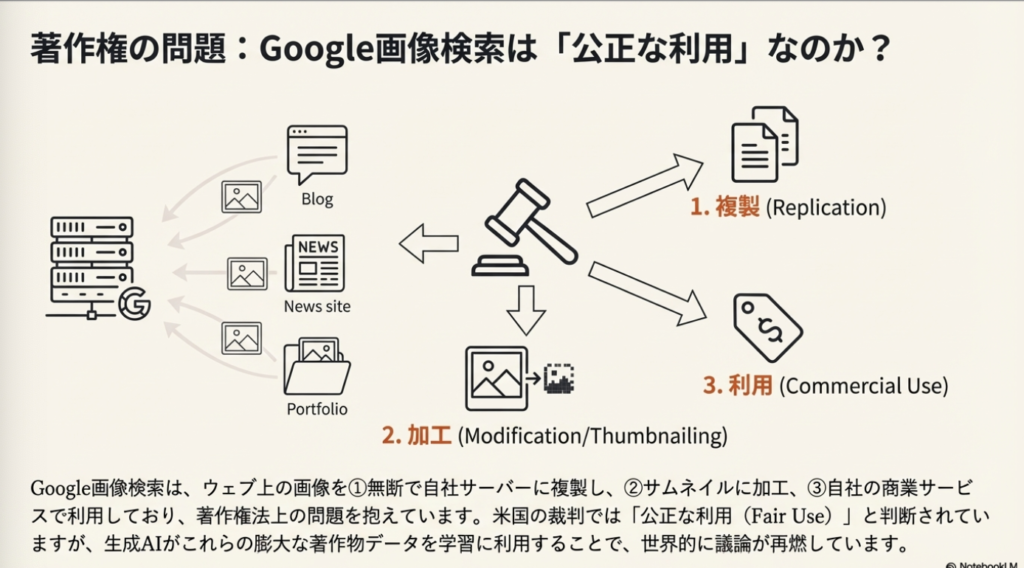

🔒 Google画像検索の問題

① 画像を複製している

② サムネイル作成時に加工している

③ 商用利用している

→ 多くの裁判が行われているがGoogleが勝訴

✅ 対策

• 画像検索時は著作権フィルターを活用

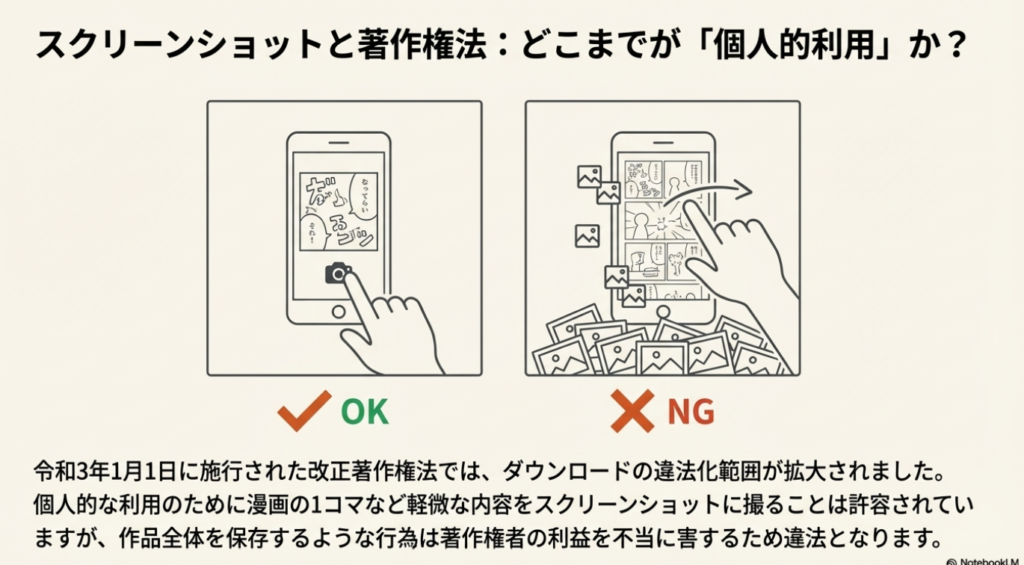

• 漫画の全ページスクショはNG

• 写り込みはOK、意図的な複製はNG

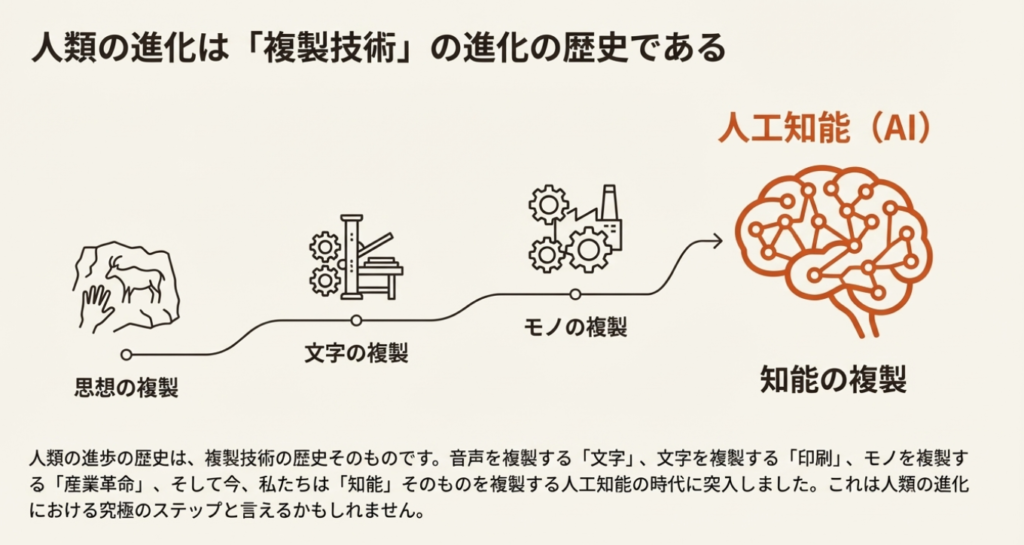

📜 人類は複製によって進化してきた

🧠 脳の複製 → 人工知能

🦾 体の複製 → ロボット

❤️ 内臓の複製 → 感情のAI化?

内臓移植で性格が変わる事例も… 内臓で考えている?

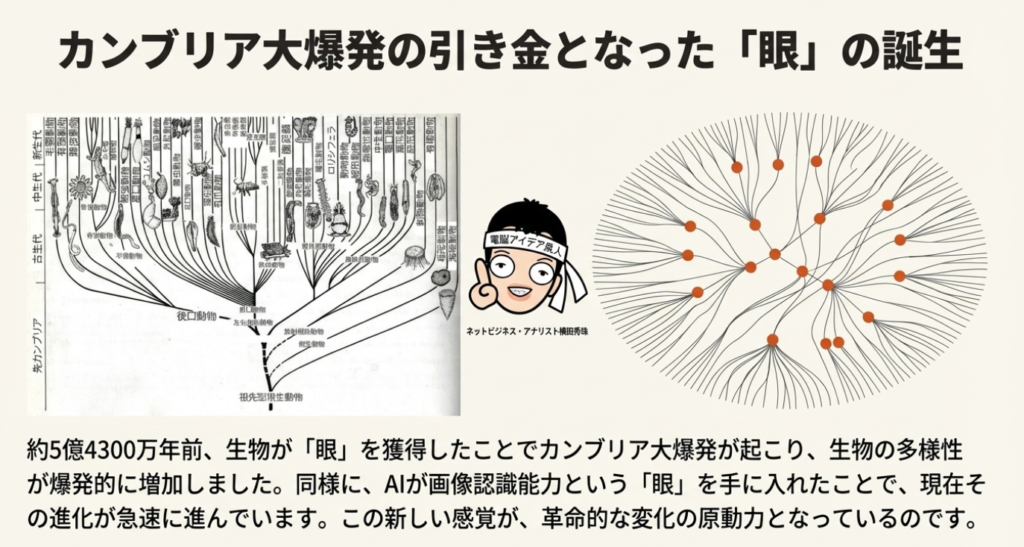

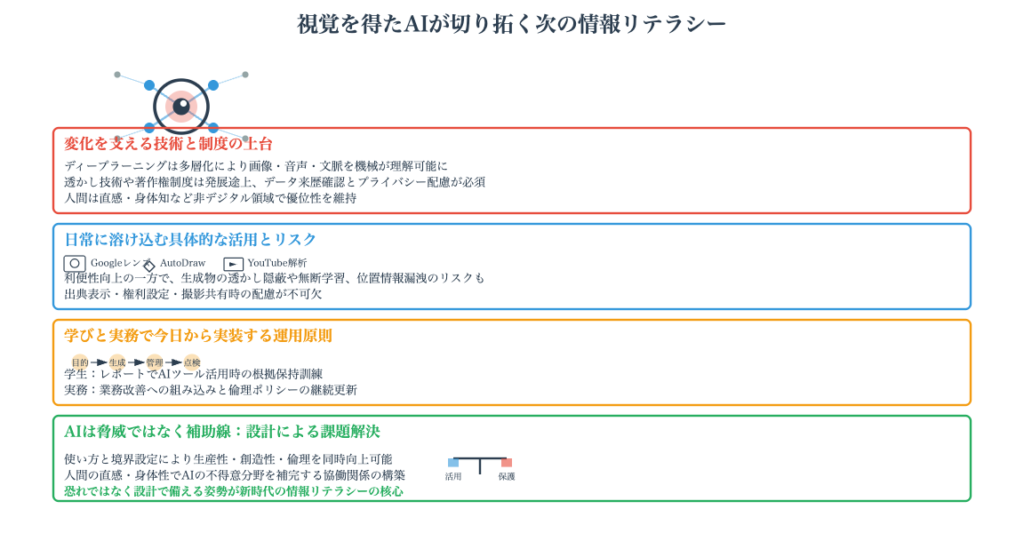

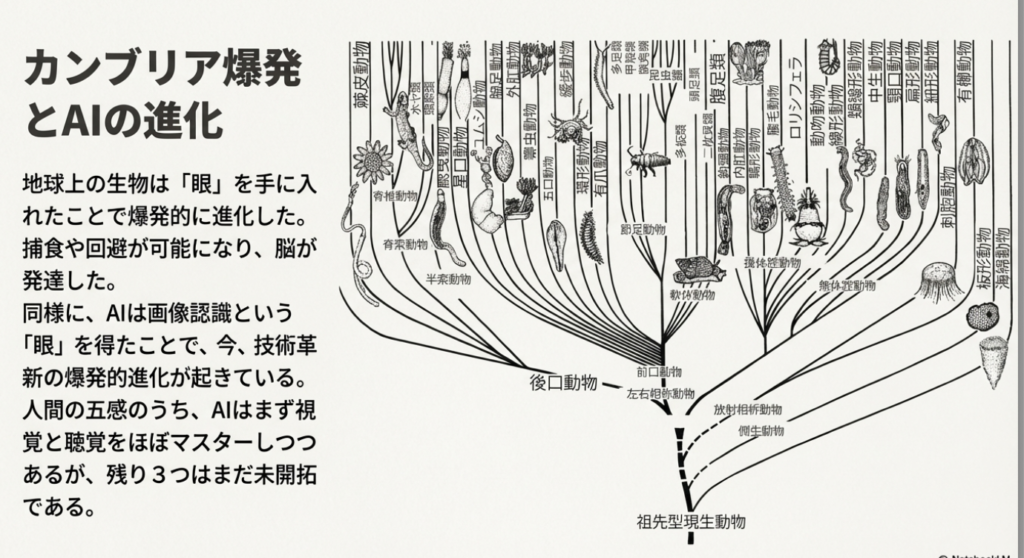

- AIは視覚と聴覚を獲得し、カンブリア紀のような進化の爆発期に

- ディープラーニングは多層構造で高精度な認識を実現

- Googleレンズや囲って検索など画像認識サービスが身近に

- 著作権とプライバシーの問題は常に意識が必要

- 人間の強みは第六感・内臓・右脳的思考にある

情報リテラシー論13画像認識と生成技術で革新’25長岡造形大学

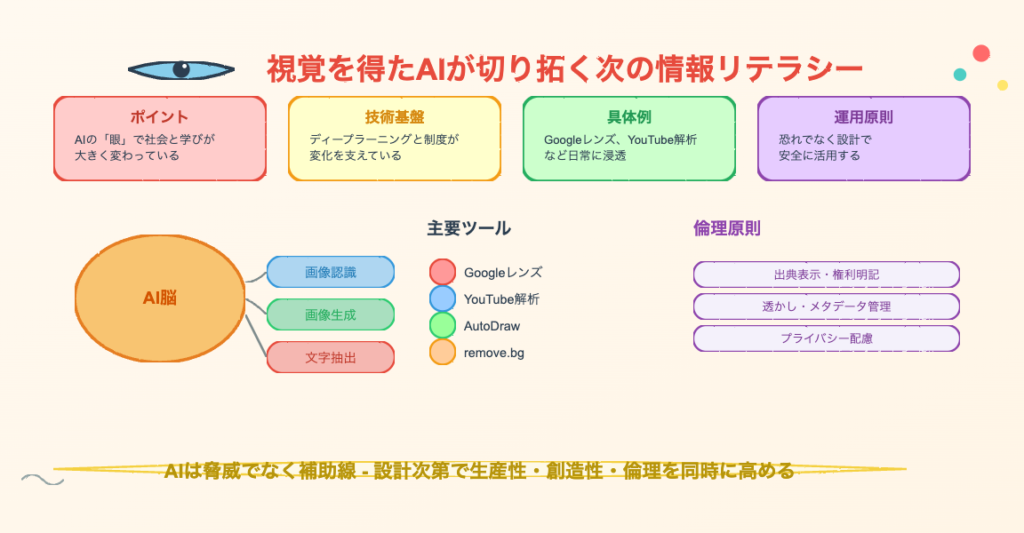

この講義では、AIが画像認識技術によって「眼」を手に入れ、カンブリア紀の生物進化のように急速に発展していることを解説。人間の五感のうち視覚・聴覚はAIが獲得したが、味覚・触覚・嗅覚はまだ実現できていない。ディープラーニングの仕組み、Googleレンズの活用、著作権問題、AI生成画像の透かし(SynthID)、NFTの可能性についても触れ、AIと人間の境界や共存について学生との質疑応答を交えながら考察している。

- はじめに

- AIが「眼」を手に入れた意味とは?カンブリア紀の大爆発との関係

- 画像認識技術の進化とGoogleレンズの可能性

- 画像認識の応用事例と著作権問題を考える

- 人類の複製技術の歴史とAI・NFTの未来

- おわりに

- よくある質問(Q&A)

はじめに

2025年12月22日、新潟県の長岡造形大学で行われた情報リテラシー論の第13回目の講義では、「画像認識と生成技術で革新」というテーマで授業が展開されました。今回の講義では、AIが「眼」を手に入れたことによって、私たちの生活や社会がどのように変化しているのかについて深く掘り下げていきます。

皆さんは普段、スマートフォンで写真を撮って検索したり、手書きの文字をテキストに変換したりしていませんか?これらの機能は、すべて「画像認識技術」というAIの進化によって実現しています。かつては人間にしかできなかった「見る」という行為を、AIができるようになったのです。

この記事では、90分の講義で話された内容を詳しく振り返りながら、画像認識技術の仕組みから最新の応用事例、そして避けて通れない著作権の問題まで、幅広く解説していきます。学生からの質問への回答も含め、AIと画像認識について理解を深めていきましょう。

AIが「眼」を手に入れた意味とは?カンブリア紀の大爆発との関係

生物の進化とAIの進化の共通点

まずは、地球上の生物がカンブリア紀に大爆発した理由についてお話しします。その理由は、生物が「眼」を手に入れたからだと言われています。同じように、AIも眼を手に入れたことで、進化が急速に進んでいるのです。

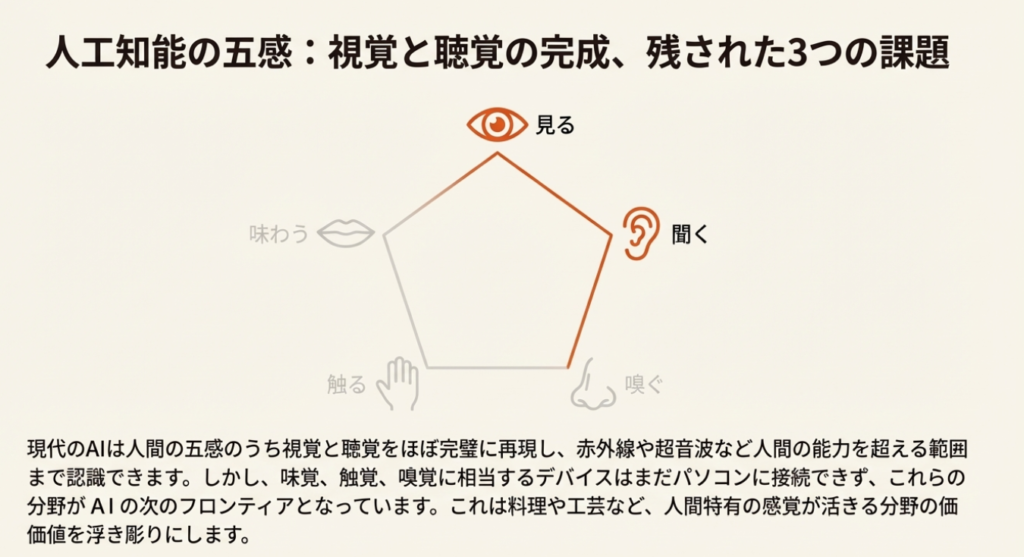

人間には視覚、聴覚、味覚、触覚、嗅覚という五感があります。この五感から考える人工知能ということで考えてみると、現在のAIは視覚と聴覚までが完璧にできるようになっています。しかし、逆に言えば残りの3つ、つまり味覚、触覚、嗅覚についてはまだできないということですね。

AIは画像認識を可能にして眼を手に入れたわけですが、この画像認識の仕組みについては、YouTubeの動画でも詳しく解説されており、非常に分かりやすい内容となっています。

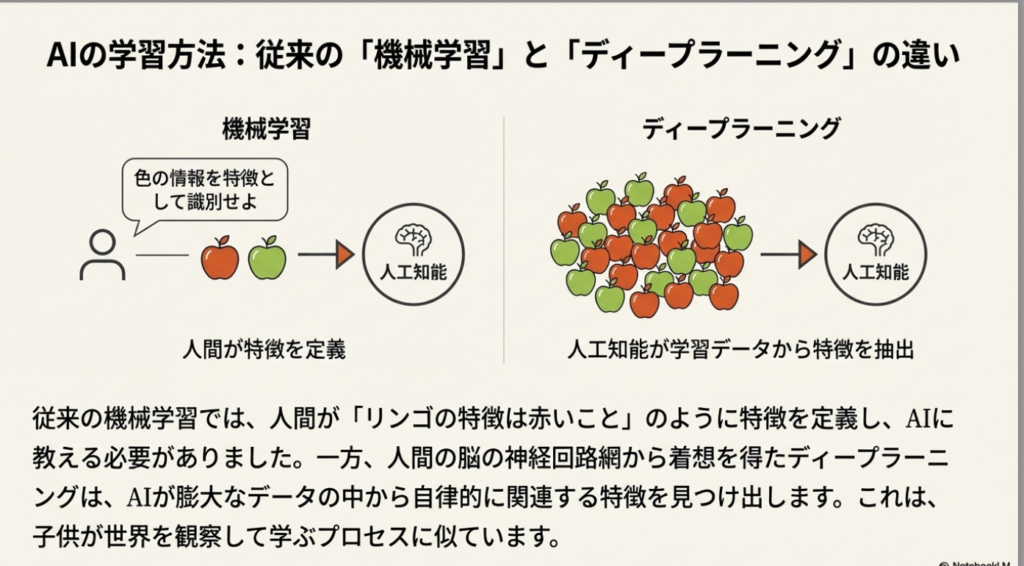

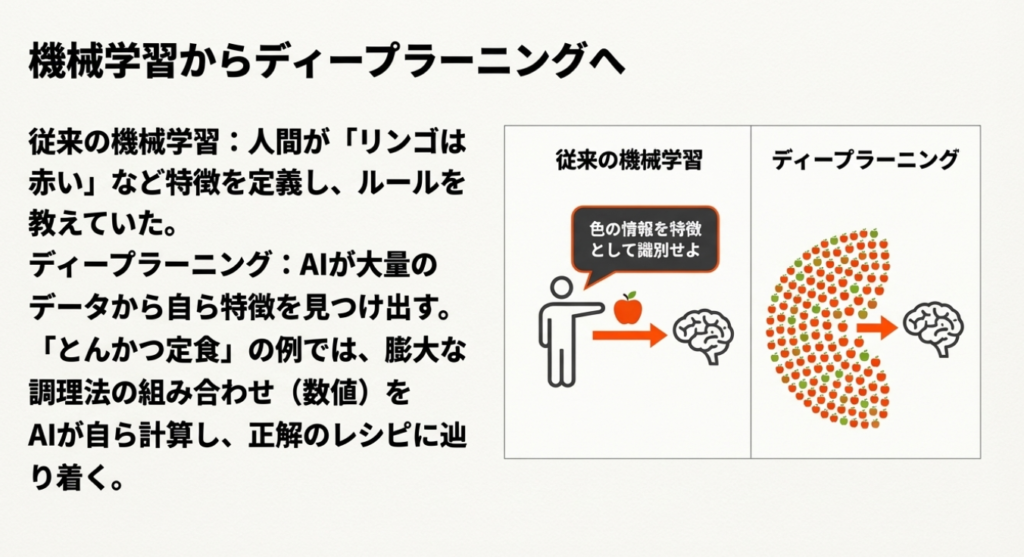

従来の機械学習とディープラーニングの違い

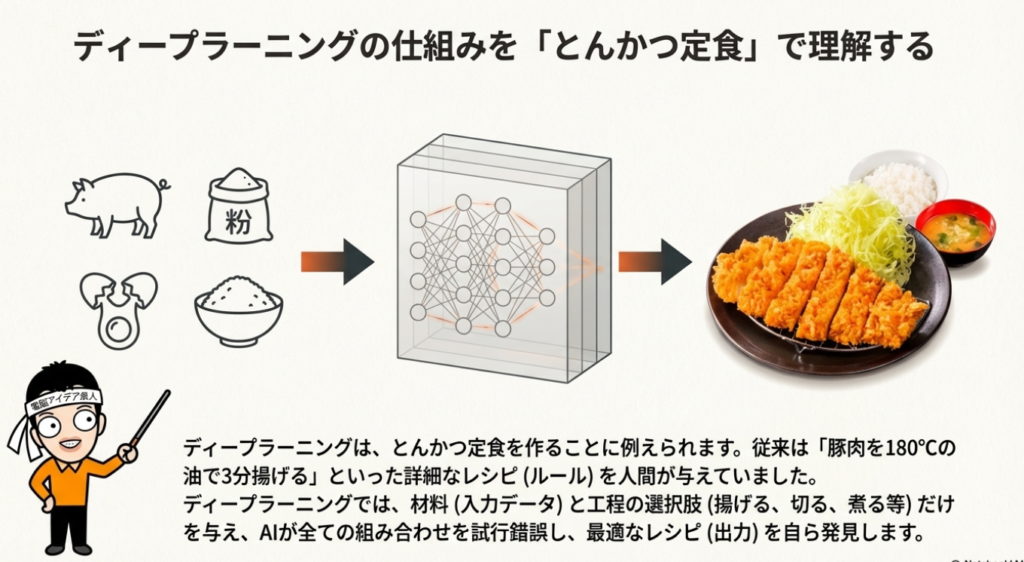

従来の機械学習とディープラーニングの違いについて説明いたしました。機械学習はちゃんとルールを決めてやっていくのに対して、ディープラーニングというのは「とんかつ定食」で説明することができます。最近ではこの話もセミナーでしなくなったのですが、この説明方法は非常に分かりやすいと評判です。

学びは「真似ぶ」から始まる

赤ちゃんは親から学ぶより、人の会話を聞いて学ぶという話があります。また、空を飛ぶという夢を実現するために、人類は鳥を模倣することから始めました。つまり、真似をすることから始めるわけですね。「学ぶ」は「真似ぶ」という言葉の通りです。

ニューラルネットワークとディープラーニングの違い

ニューラルネットワークとディープラーニングの違いについても解説しました。ニューラルネットワークというのは階層が浅いのに対して、ディープラーニングというのはこの階層を深くして、より認識させるために、いわゆるパラメーターというものをたくさん与えるわけなんですね。数字で計算していくということになります。

画像認識技術の進化とGoogleレンズの可能性

画像検索の始まり

ちょっと前提がありまして、2010年6月にAmazonフォト検索は書籍の表紙の写真で探せるということで、当時は画期的だったんですね。それからはスマホをかざすだけで物を認識して検索できるアプリが多数出てきまして、それを束ねたのがGoogleレンズだということですね。

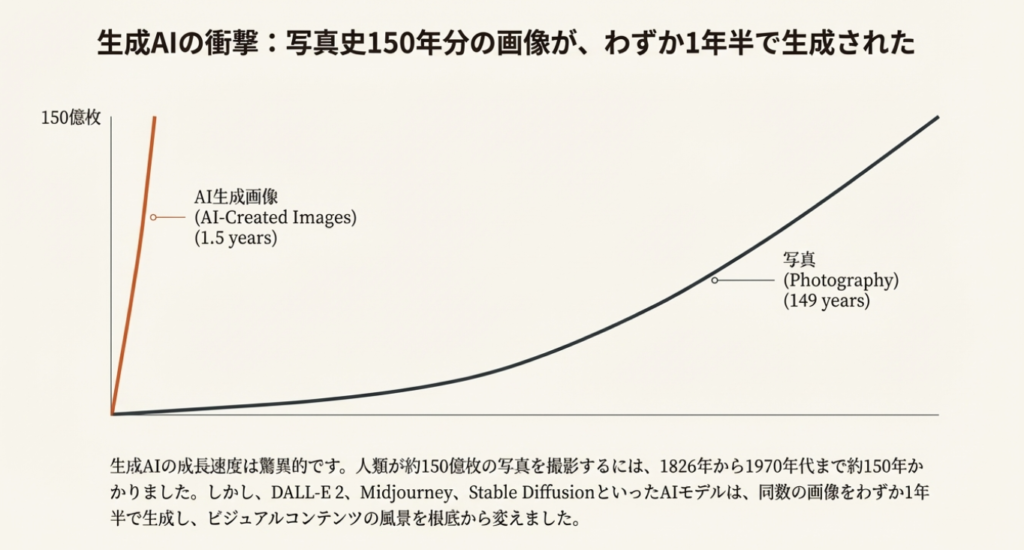

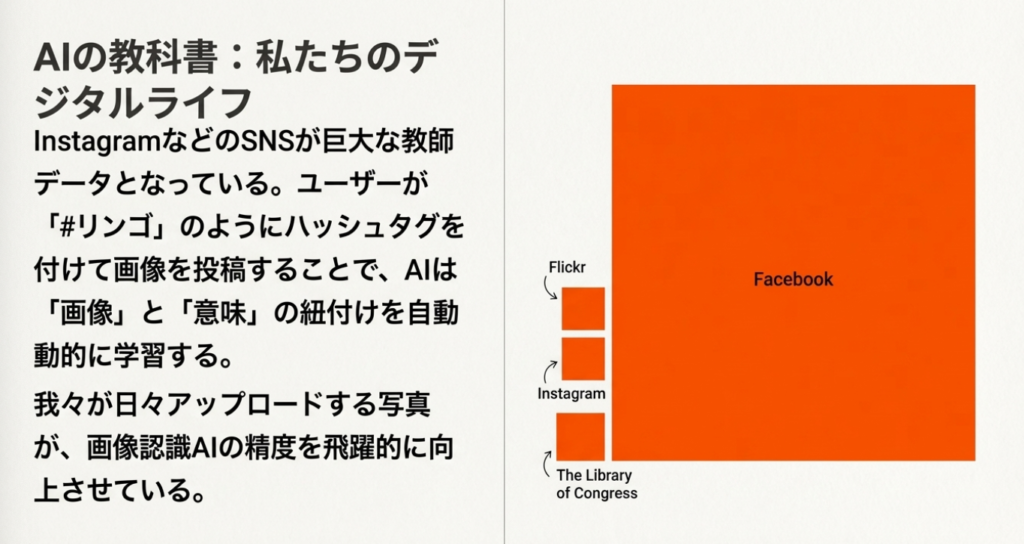

そして撮った写真の2割をFacebookにアップし、今までの1割は直近1年で撮影したものだという話があります。これは2011年のニュースなので、今ならもっとすごい数字になっていますねという話ですね。今なら160年分に匹敵するという話なんです。

画像認識技術の発展

altタグをHTMLで入れなくても、画像に書かれた文字をテキストとして認識できるようになったのは2014年からですね。これは今ではGoogleの「囲って検索」でできるようになりました。ということでGoogleレンズですね。これはPCブラウザでも2024年8月1日から可能になっています。

YouTube内のテキストや画像なんかも検索できます。そしてLINEに画像を送るとAIが3秒で文字起こしするという「ばりぐっどくん」というサービスもあります。これは授業で話さなかったけど、これも便利ですね。

スマホの中の写真もキーワード検索に対応したのは2015年、16年ぐらいからになっています。さらに手書きの文字だってGoogleレンズで認識できるようになっています。

囲って検索機能の普及

スマホでは「囲って検索」というものがAndroidに続きまして、iPhoneの方でも今使えるようになっていますね。これは実演してお見せしました。

そしてChatGPTの画像認識によって、その自分の撮影場所がバレてしまう、住所がバレてしまう可能性があるので気をつけましょうねという話もいたしました。

AIを活用した様々なサービス

さらにはお絵かきをGoogleのAIが補正するというAutoDraw(オートドロー)という機能があります。これは学生さんにはこういうのが好きかなということで紹介しています。さらに、今書いている途中から人工知能AIが絵を認識し答えるサービスということで「Quick, Draw! with Google」のサービスなんかも紹介しました。

そしてAIの手助けで漫画キャラクターが描けるというGoogleの「Giga Manga」というサービスなんかも紹介しましたね。

背景削除や画像編集ツール

ここからちょっと省きましたが、remove.bgですね。背景を消すことができれば、こんなものは今全然びっくりしないですよね。当たり前にもうできるようになりましたからね。Canvaでもできるし、スマホのアプリでもできますからね。

画像をなぞると消える、ウェブブラウザでも使えるという「Cleanup.pictures」とかですね。さらにはAIがこの動画に写っているものでさえタグ付けできる。こんなものは今全然びっくりしないですよね。

画像で切り抜き、背景や画像を動画に変換できる。これもZoomが出て当たり前になりましたね。さらには2次元のプロフィール写真をアップすると3次元に加工させるものとかもあります。「Sora」の話なんかもありますけど、これは省略しました。

画像認識で値札がつけられないパン屋さんのレジを業務改善という話なんかも、このままで飛ばしましたね。

画像認識の応用事例と著作権問題を考える

画像認識の面白い応用事例

ストックホルムの道路に設置されたスピードカメラくじ、これは面白いんですけどね。スピードが出るとこれが認識して、ちゃんと守ると賞金がもらえるという仕組みが面白いですよね。これは紹介しました。

AIカメラが顔認識し、居眠りや脇見などを感知すると警告があるということですね。

AI自動撮影カメラ、PowerShot PICKを使うと遠隔操作もできるし、あとは自動的に写真をAIが撮ってくれるので便利だよねという話ですね。

MicrosoftのiOSアプリの「Seeing AI」というのがありましてできるんだけど、こんなものは今普通にGoogleレンズでできるようになりましたからね。

ということでAdvanced Voice Mode(アドバンスボイスモード)にビデオカメラ機能がついたことによって、これもちょっと実演しましたね。すごかったですね。

そしてGeminiでショート動画のタイムスタンプ、字幕、会話、シーンの解析なんかもできるようになりましたということですね。

Google画像検索と著作権の問題

そしてGoogle画像検索が何が問題なのかということで、著作権違反してるよねと。そもそも画像を複製しているし、サムネイルにする時に加工しているし、そして商売に使って利用しているわけ。なんで3つの違反してるんじゃないの?ということでたくさん裁判が行われているんだけど、残念ながらGoogleは勝っているということですね。

著作権で絞り込む機能も画像検索についているので使いましょうということです。

AIが生成した画像の識別方法

これをやってみました。今回新しく出たスライドなんだけど、GoogleはAIの画像生成にSynthIDという制度を使っています。AIを入れているので認識できるんだけど、その代わり他のAIサービスを使うと認識できないということですね。

スクリーンショットと著作権

スクショを撮ってスマホに保存する人が若い世代ほど多いですが、これも違法にあたりますので注意しましょう。ダウンロード規制の著作権法改正案というのが出ていまして、スクショの写り込みはOKだけど、さすがに漫画を全部スクショ撮ったりするのはやばいですよということが言われています。

人類の複製技術の歴史とAI・NFTの未来

複製技術の進化と人類の発展

そして人類による技術の進化は複製技術の進化と再現による加速化ということで、全てここに書かれている通りなんですけど、複製することによって人類は進化をしてきたわけですね。

最後には脳の複製をやろうとしているのが人工知能ですね。次にあるのはこの体の複製をやろうとしているのがロボットですよね。そしてあとはこの感情ですね。内臓の複製はできるんだったら、もしかしたら人工知能が完璧になるかもしれないねという話ですね。

NFTとAI時代の関係

そして今日冒頭にNFTの話をいたしました。NFTってなんぞやという話なんだけど、このAI時代、インターネット時代にNFTがもし最初からあればという話なんですね。これは残念ながらないので今の状態になってしまったんだけど、これが組み合わさっていれば結構いい平和な時代が来たかもしれないんですよね。NFTの話は動画で見ていただきました。

学生からの質問への回答

では学生からの質問にも答えていきましょう。

Q: AIが味覚、触覚、嗅覚を手に入れたら人間の立場がなくなるので怖いです。

これでもまだいけるんですよね。何かというと、第六感を人間は持っているということと、そして感覚としてはこの5つなんですけど、それ以外にも人間は考える場所というのが脳だけではなくて、実は体とか内臓でも考えているんですね。この辺までは今回話しませんでしたけど、次回話しましょうかね。これは結構面白い話があるので、楽しみにしていてください。ありがとうございます。

Q: AIの進化している部分と残り3つの感覚は全然AI管理が効かないなと気づかされました。

そうですね、ここの部分が全然全くついていけていない、まだできてないんですよね。なので、ここが逆に言えば右脳だったりとか人間の強みかなと思ったりもしています。

Q: 物を判断するのは生きているうちに自然に身につく能力ですが、AIに学習させるのは大変だと思いました。

そうなんですよね。ただ、人間も結局経験ということなんですよね。経験がある人というのはたくさん物を見たり、たくさん耳で聞いたり、触ったり感じたりしている人の方が経験があるというものなんだけど、これには限界があって、どう考えてもAIの方が学習させるのは得意なんだけど、それはあくまでもデジタルの話なんですよね。アナログのものを学習させるのはやっぱり難しいという問題がありますね。

Q: AIの実存問題に関する話を聞いたことがあります。もしもAIが五感を得た場合、AIは現実に実存できているということになるんでしょうか?

これは内臓の問題と身体の問題というのがあって、人間は実は内臓で考えているんですよ。これは分かりやすい話があって、その内臓を移植することがあったとしますね。移植すると実は性格が変わると言われていて、だから内臓が考えているんじゃないかということが言われているんですね。この話もまた次回しましょうかね。

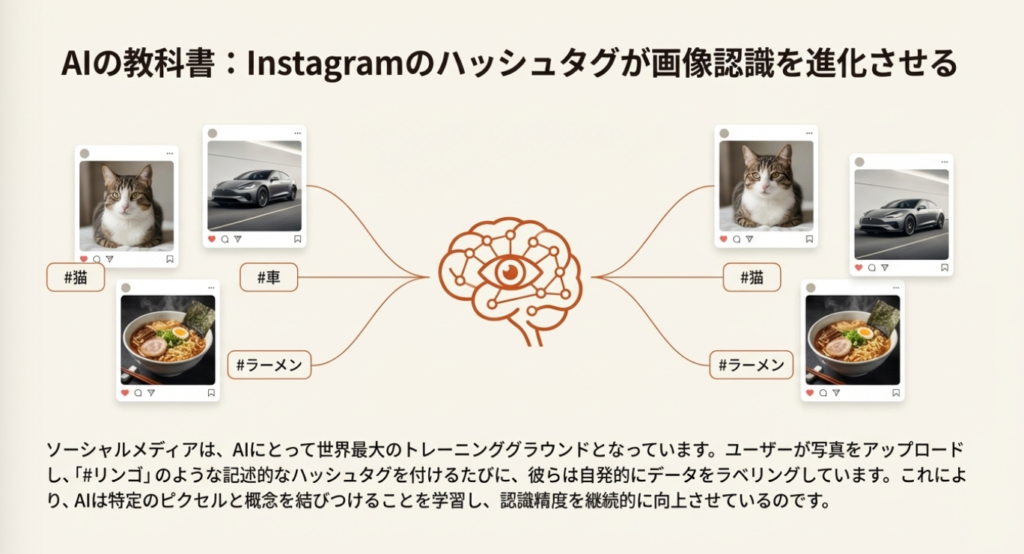

Q: 人がInstagramに投稿した写真などのデータをAIに学習させるためにビッグデータとして保存しているというのを初めて知って驚きました。

これでも賢いですよね、仕組みとしてね。勝手にこうタグ付けすることによって、この写真はこれだという風に、以前であればaltタグというものがこれにあたりますよね。写真にALTを入れることによって写真と意味を紐付けすることができるんだけど、Instagramなんかはまさにそうですよね。しかも説明文を書いているからね。補足で画像の説明を文章で書いてくれているわけだから、こんなにいいサービスはないですよね。

Q: ディープラーニングの仕組みを初めて知りました。とても分かりやすかったです。

ありがとうございます。とんかつ定食の話ですね。

Q: ディープラーニングはあまり理解できていなかったので分かりやすかったです。

ありがとうございます。

Q: ディープラーニングのことを理解できました。思っていたよりも機械だからできる力だったんですね。

そうなんですよね。逆にこの力技というやり方をできるようになったのが、そのコンピューターですね。その計算能力の精度が上がったということですね。早くなったということですよね。力技でもスピードが遅かったら学習が遅いので間に合わないわけですよね。

Q: 言語化が難しい見た目のものを調べる時にGoogleレンズによく助けられます。

そうなんですね。僕は全然使わないので、逆にこういう感覚は持っておきたいなと思いますね。

Q: Googleレンズは対応していますが、物を認識してくれる能力が上がって検索が便利になったなと思いました。

みんな活用してるんですね。

Q: 統一したIDを作らないと、これから問題が増えていく一方だと思います。

画像のIDですね。作っていくというのはすごく大事かなと思うんだけど、ただね、このブロックチェーンの仕組みも問題があって、これも膨大な量になるんですよ。これが回すのがまた大変になるので、その問題があるんですけどね。

Q: TwitterがAI学習を自動的にOKにしていたという話がよく分からなくて怖いです。

こういうものがIT企業にはありがちなので、リテラシーを学ぶという話なんですよね。

Q: 自分で描いたと言いながら、AI生成の透かしを隠しもしない画像をたまに見かけます。

そうなんですね。正直に言えばいいと思うんですけどね。こういう風に分かってしまいますからね。

Q: ここ数年で自動認識の能力が本当に上がったなと思いました。

上がりましたよね。やっぱりこのAIが認識するのと、AIが考えることがセットになると一気に上がりますよね。

Q: よく読み方が分からない漢字をGoogleレンズにかけて調べます。

いいことですね。

Q: AIの生成画像に見えない透かしも入っていることを初めて知りました。

これは大事ですね。

Q: Googleレンズの精度が思ったより高くて驚きました。写真検索できて便利ですが、うっかり写真に写ってしまったものの情報が全て漏洩してしまいそうで怖いです。

逆にそうとも言えますよね。

Q: 誰でも絵が描けるようになるんですね。

これはGoogleの漫画サービスの話ですね。

Q: 手書きで書いたメモを文章に起こしてくれる機能があることを初めて知った時は驚きました。

今すごいですよね。

Q: どんどん世界がAIに包まれていって、自分が助かることもあれば支配されていくような気がして、少し不安も感じます。

Q: Google Pixelの囲って検索がGoogleアプリに入っていたらiPhoneでもできることを知って驚きました。

そうなんです。できるようになったんですね。

Q: AIに侵食されすぎると困るからほどほどにしてほしい。

そうですね。ありふれたものを作り出したり、回答するということですね。

Q: 先ほど動画でAIは人間社会を支配することはないと述べられていましたが、裁判の判決にまで影響してくると、人間社会に深く侵食していくように感じられて恐ろしいなと思いました。

Q: 美術館の音声ガイドのようなものがスマホがあれば身近にできるようになったと驚きました。

ということで今日は、画像認識と、そして生成技術の革新についてお話しいたしました。

おわりに

今回の情報リテラシー論第13回では、「画像認識と生成技術で革新」というテーマで、AIが「眼」を手に入れたことの意味と、その影響について詳しく学びました。

カンブリア紀に生物が大爆発した理由が「眼」を手に入れたことにあるように、現代のAIも画像認識技術を獲得したことで急速な進化を遂げています。しかし、人間の五感のうち、AIが完璧に再現できているのは視覚と聴覚のみであり、味覚・触覚・嗅覚についてはまだ実現できていません。これは人間の強みが残されている領域とも言えます。

Googleレンズをはじめとする画像認識技術は私たちの生活を便利にしてくれる一方で、プライバシーの問題や著作権の問題など、新たな課題も生み出しています。特に、AI生成画像の識別や、スクリーンショットによる著作権侵害など、リテラシーとして知っておくべきことが増えています。

来月の講義では、人間が内臓や身体でも考えているという興味深い話題についても触れる予定です。AIと人間の関係を考える上で、ぜひ次回もご期待ください。

よくある質問(Q&A)

Q1: ディープラーニングと機械学習の違いは何ですか?

A1: 従来の機械学習はルールを人間が決めて学習させる方法ですが、ディープラーニングはニューラルネットワークの階層を深くして、大量のパラメーターを使って自動的に特徴を学習させる方法です。講義では「とんかつ定食」の例えで分かりやすく説明されました。コンピューターの計算能力が向上したことで、この力技のような学習方法が可能になりました。

Q2: AIが五感すべてを手に入れたら、人間は不要になりますか?

A2: AIが味覚・触覚・嗅覚を手に入れたとしても、人間には「第六感」があります。また、人間は脳だけでなく、身体や内臓でも考えていると言われています。内臓移植をすると性格が変わるという話もあり、AIがこれらを完全に再現するのは現時点では難しいと考えられています。

Q3: 画像認識技術で気をつけるべきプライバシーの問題は?

A3: ChatGPTの画像認識機能などを使うと、撮影した写真から撮影場所や住所が特定されてしまう可能性があります。また、Googleレンズの精度が高いため、写真に写り込んだものの情報が漏洩するリスクもあります。SNSに写真をアップする際は、背景に写っているものにも注意が必要です。

Q4: スクリーンショットを撮ることは著作権違反になりますか?

A4: スクリーンショットの写り込み程度であればOKとされていますが、漫画を全ページスクショで保存するような行為は著作権法違反にあたります。ダウンロード規制の著作権法改正案により、若い世代に多いスクショ保存の習慣も、内容によっては違法となる可能性があるので注意しましょう。

Q5: AI生成画像かどうかを見分ける方法はありますか?

A5: GoogleはAI画像生成に「SynthID」という電子透かし技術を使用しています。これにより、Googleが生成したAI画像は識別可能です。ただし、他のAIサービスで生成された画像は、この方法では識別できません。AI生成画像には見えない透かしが入っていることもあるので、画像の出所には注意が必要です。

詳しくは15分の動画で解説しました。

https://www.youtube.com/watch?v=4mQzQ3KHP58

0:00 📚 導入・講義概要の紹介

1:08 🏫 大学の様子と雪の話

2:12 👁️ AIが目を手に入れた進化とディープラーニング

3:14 🔍 画像検索の歴史とGoogleレンズの登場

4:20 ✍️ 手書き文字認識と囲って検索機能

5:21 🎨 背景除去・自動タグ付けなどのAI画像編集技術

6:25 📷 AIカメラと顔認識・自動撮影機能

7:29 ⚠️ AI透かしとスクショの著作権問題

8:37 🔗 複製技術の進化とNFTの意義

9:44 💬 学生Q&A:AIの五感と人間の強み

10:53 🧠 内臓で考える?人間の思考とSNSデータ活用

11:54 🤖 ディープラーニングの仕組みとGoogleレンズ活用例

13:00 🔎 AI生成画像の透かし検出と自動認識の進化

14:04 👋 まとめと締めくくり

上記の15分の動画はYouTubeメンバーシップの

デイリー会員(190円/月)に限定公開しています。

詳しくは以下をご覧ください。

https://yokotashurin.com/youtube/membership.html

YouTubeメンバーシップ申込こちら↓

https://www.youtube.com/channel/UCXHCC1WbbF3jPnL1JdRWWNA/join

情報リテラシー論13画像認識と生成技術で革新’25長岡造形大学

👁️ 画像認識 AIが画像の内容を理解し識別する技術のこと。人間が目で見て物を認識するように、AIもカメラやセンサーから取得した画像データを分析し、物体・文字・顔などを特定できる。Googleレンズやスマホの写真検索機能など、日常生活で広く活用されている。AIが「眼」を手に入れたことで、進化が加速したと言われている。

🧠 ディープラーニング 人間の脳の神経回路を模倣した多層構造のニューラルネットワークを用いた機械学習手法。従来の機械学習と異なり、大量のデータから自動的に特徴を抽出し学習する。講義では「とんかつ定食」の例えで説明され、パラメーターを増やすことで認識精度が向上する仕組みが解説されている。

🔗 ニューラルネットワーク 人間の脳の神経細胞(ニューロン)の仕組みを模倣したAIの計算モデル。入力層・中間層・出力層で構成され、データを処理して学習する。ディープラーニングとの違いは階層の深さで、ニューラルネットワークは階層が浅く、ディープラーニングは深い多層構造を持つ点が特徴である。

🔍 Googleレンズ スマホのカメラで撮影した画像から情報を検索できるGoogleのサービス。文字認識、物体識別、翻訳、植物・動物の特定など多彩な機能を持つ。2024年8月からはPCブラウザでも利用可能になった。言語化が難しいものを調べる際や、手書き文字の認識にも対応しており、学生からも活用されている。

⭕ 囲って検索 スマホ画面上の任意の部分を指で囲むだけで、その対象を検索できる機能。Androidで先行導入され、iPhoneでもGoogleアプリ経由で利用可能になった。従来のようにテキスト入力する必要がなく、視覚的に気になったものをすぐに調べられる直感的な検索方法として注目されている。

🖐️ 五感(AI) 人間が持つ視覚・聴覚・味覚・触覚・嗅覚の5つの感覚。現在のAIは視覚と聴覚をほぼ完璧に再現できるが、残りの3つ(味覚・触覚・嗅覚)はまだ実現できていない。この限界が人間とAIの違いであり、人間の強みとも言える。また人間には第六感や内臓で考える能力もあるとされる。

🏛️ カンブリア紀 約5億4千万年前、地球上の生物が爆発的に多様化した時代。その理由は生物が「眼」を獲得したからとされる。講義ではこの進化になぞらえ、AIも画像認識という「眼」を手に入れたことで急速な進化が始まったと説明している。視覚の獲得が進化の鍵という点で、生物とAIに共通点がある。

🔏 SynthID Googleが開発したAI生成画像に埋め込む電子透かし技術。人間の目には見えないが、AIは検出できる仕組みで、AI生成コンテンツを識別するために使われる。ただし他社のAIサービスでは認識できないという課題がある。AI生成物の真偽を判断する上で重要な技術として注目されている。

©️ 著作権(画像検索) Google画像検索は、画像の複製・加工・商用利用という3つの点で著作権違反の可能性が指摘されているが、裁判ではGoogleが勝訴している。スクリーンショットで画像を保存する行為も違法になる可能性がある。著作権で絞り込む検索機能の活用や、法改正の動向への注意が呼びかけられている。

🎨 NFT Non-Fungible Token(非代替性トークン)の略で、デジタルデータに唯一性を証明するブロックチェーン技術。複製が容易なインターネット時代において、オリジナル作品の所有権を明確にできる。講義では、もしインターネット誕生時からNFTがあれば、著作権問題も違う形になっていた可能性があると述べられている。

超要約1分ショート動画こちら↓

https://www.youtube.com/shorts/LChnYmh2ot4

情報リテラシー論13画像認識と生成技術で革新’25長岡造形大学

AIが「眼」を持ったら世界はどう変わる?〜カンブリア紀の進化ととんかつ定食で学ぶ、画像認識のすごい仕組み〜

導入:AIに「眼」ができた日

もし、AIに「眼」がなかったら、現代の私たちの生活はどうなっていたでしょうか?自動運転も、スマホの顔認証も、そして今話題の画像生成AIも存在しなかったかもしれません。AIが「眼」を持つ、つまり画像認識技術を獲得したことは、それほどまでに革命的な出来事でした。

この革命は、地球の生命史における一大イベント「カンブリア爆発」にたとえることができます。約5億4000万年前、生物が初めて「眼」を獲得したことで、生存戦略が劇的に変わり、爆発的な勢いで多様な種が誕生しました。それと同じように、AIも「眼」を手に入れたことで、その進化のスピードを一気に加速させたのです。この記事では、AIがどのように世界を「見て」いるのか、その驚くべき仕組みと未来への影響を、身近な例えで解き明かしていきます。

——————————————————————————–

カンブリア爆発という壮大なアナロジーは、AIの進化を理解するための鍵となります。では、具体的に生物の進化とAIの進化にはどのような共通点があるのでしょうか。

——————————————————————————–

1. AIにおける「カンブリア爆発」とは?

カンブリア紀の生物にとって、「眼」を持つことは生存そのものを左右するほどの大きな変化でした。具体的には、以下のような利点がありました。

• 食料の発見: 目で獲物や食べ物を見つけ、効率的に食料を得られるようになりました。闇雲に動き回る必要がなくなったのです。

• 危険の回避: 天敵をいち早く認識し、食べられる危険から逃げ延びることができるようになりました。生存確率が飛躍的に向上しました。

• 知性の発達: 見たものを記憶し、「あそこには美味しいものがある」「あれは危険だ」と考えることで知性が発達しました。キリンの首が高い場所の食べ物を見るために長くなったように、視覚情報は多様な進化のきっかけとなったのです。

AIの進化は、この生物の進化と驚くほど似た道を辿っています。画像認識技術という「眼」を手に入れる前、AIは与えられたデータを計算するだけの存在でした。しかし、「見る」能力を獲得したことで、AIは単なる計算機から、現実世界を認識し、自ら判断し、学習する存在へと劇的に進化したのです。生物が眼によって生存競争を勝ち抜いてきたように、AIもまた、眼によってその能力を爆発的に進化させ始めました。

AIが生物と同じように「眼」で世界を認識し始めたことはわかりました。では、具体的にAIはどのようにして目の前にあるモノが「何か」を理解しているのでしょうか?

——————————————————————————–

2. AIはどのように「モノ」を見分けるのか?

私たち人間にとって、目の前にあるリンゴを「リンゴだ」と認識することは瞬時にできる簡単なことです。しかし、コンピューターにとってこれは非常に難しい課題です。

AIがリンゴを「リンゴ」だと認識するプロセスは、以下のステップで行われます。

1. 大量のデータ学習 AIに「これはリンゴです」とラベル付けされた、様々な色、形、大きさのリンゴの画像を何十万枚も読み込ませ、徹底的に学習させます。

2. 特徴の抽出 AIは学習データの中から、「リンゴらしさ」を構成する特徴(例:丸い形、赤い色、ヘタの存在、大きさの比率など)を自動で抽出し、データとして蓄積します。

3. 比較と判断 新しい画像が提示されると、その画像から抽出した特徴を、学習済みの膨大な「リンゴらしさ」のデータと照合します。そして、最も特徴が近いものを「リンゴ」だと判断するのです。

このプロセスは単純に見えるかもしれませんが、例えばトマトやパプリカのように、色や形がリンゴとよく似た物体との区別は簡単ではありません。AIは、お尻の部分のくぼみ具合や、ヘタの周りの形状といった、人間でも意識しないような細かい特徴の違いをデータから学び、高い精度で見分ける能力を身につけているのです。

——————————————————————————–

AIが大量のデータから特徴を学ぶ基本は理解できました。しかし、一つひとつ特徴を教えていては、あまりにも非効率です。AIの学習方法は、この課題をどのように乗り越え、進化したのでしょうか。

——————————————————————————–

3. AIの賢い学習法:「とんかつ定食」でわかるディープラーニングの秘密

従来のAIの学習方法(機械学習)には限界がありました。リンゴの例で言えば、「赤いリンゴ」「青いリンゴ」と、一つひとつ人間が「こういう特徴のものがリンゴだよ」と丁寧に教える必要がありました。これでは、赤と青の中間色のような未知のパターンのリンゴが現れたとき、AIはそれをリンゴだと認識できません。

この限界を打ち破ったのが「ディープラーニング」です。この革新的な仕組みを、私たちの食卓に馴染み深い「とんかつ定食」を例に解説します。

| 要素 | とんかつ定食の例え | ディープラーニングの仕組み |

| 材料 | 豚肉、小麦粉、キャベツ、米など | AIに与えられる膨大な「データ」 |

| 調理法(動詞) | 「切る」「揚げる」「盛る」など | AIに与える処理の指示(動詞) |

| レシピ(数字) | 「豚肉を100g」「180度で揚げる」など | AIが自ら発見する最適な数値の組み合わせ |

このテーブルが示すように、ディープラーニングの本質は、人間がAIに全てを教える必要がない点にあります。

人間がやることは、「材料(データ)」「調理法(動詞)」「レシピ(数字)」自力で見つけ出します。「豚肉を1mmで切って10度で揚げる」「10cmで切って300度で揚げる」…といった天文学的な数の組み合わせをすべて試し、正解に最も近いレシピを導き出すのです。このおかげで、AIの学習能力は飛躍的に向上し、複雑な画像認識も可能になりました。

——————————————————————————–

AIの驚異的な学習能力には目を見張るものがあります。しかし、それは万能なのでしょうか?AIにはまだできないこと、つまり人間が持つ独自の能力との違いはどこにあるのかを見ていきましょう。

——————————————————————————–

4. 人間ならではの強み:AIにはまだない「感覚」

人間の五感(視覚、聴覚、嗅覚、触覚、味覚)と、現在のAIが持つ能力を比較してみましょう。

AIは、カメラやマイクを通じて視覚と聴覚ではすでに人間を超える能力を発揮することがあります。例えば、赤外線カメラで暗闇を見通したり、超音波を聞き取ったりすることは、人間には不可能です。

一方で、現在のAIにはまだ**「嗅覚」「触覚」「味覚」**が備わっていません。これはAIと人間の決定的な違いであり、私たちの強みでもあります。

この違いがなぜ重要なのかを、「ハンバーグの食レポ」を例に考えてみましょう。AIが食レポを書こうとしても、以下のような表現は決してできません。

• 食欲をそそるチーズの香りを嗅ぐことができない。

• 肉汁が口の中でとろける食感を味わうことができない。

• ナイフを入れたときのふっくらとした柔らかさを感じることができない。

このように、残り3つの感覚を駆使した豊かな表現や、手先を使った繊細な創作活動は、AIにはまだ模倣が難しい、人間独自の領域です。AI時代において、私たち人間が持つべき価値とは何かを考える上で、この「感覚」は非常に重要なヒントを与えてくれます。

——————————————————————————–

AIの能力と人間の能力、その両方を理解した上で、私たちは未来とどう向き合っていくべきでしょうか。最後に、本記事の要点をまとめます。

——————————————————————————–

まとめ:AIの「眼」と共に未来を考える

この記事では、AIが「眼」を持つことの重要性を、生物の進化になぞらえて解説し、その裏側にあるディープラーニングという賢い仕組みを見てきました。その進化のスピードは、私たちの想像を絶するものです。

ある調査によると、人類が写真技術を発明してから最初の149年間で撮影した写真の枚数と、AIがここ1年半で生成した画像の枚数が、ほぼ同じだと言われています。これは、AIの進化がまさに「カンブリア爆発」と呼ぶにふさわしいスケールで起きていることを示す、衝撃的な事実です。

AIの進化は驚異的ですが、匂いや味、手触りといった人間にしか持ち得ない感覚も確かに存在します。AI技術を正しく理解し、いたずらに恐れるのではなく、その能力を最大限に活用すること。そして、AIには真似のできない人間ならではの感性や創造性をどう磨き、活かしていくか。それを考え、行動することが、これからの時代を豊かに生きるための鍵となるでしょう。

#情報リテラシー論 #長岡造形大学 #横田秀珠 #情報リテラシー #メディアリテラシー #ITリテラシー